BDD: LA QUALITE, UN INVESTISSEMENT DURABLE

Après le CRM, la gestion de la qualité des données - la DQM - est la nouvelle préoccupation des responsables des systèmes d'information. Etre équipé de solutions complexes ne suffit plus à rester compétitif si les données ne sont pas correctes. La DQM a vocation à résoudre les problèmes liés à la qualité des bases en apportant des outils correctifs mais surtout une méthodologie préventive.

Je m'abonneSommaire du dossier

-

Fichiers clients et bases de données

Fichiers clients et bases de données

- Vocabulaire de la base de données et de la gestion de fichiers clients

- Constituer une base de données

- Qualifier et enrichir sa base de données

- Analyser les données

- Les spécificités du B to B

- Gérer sa BDD

- Les métiers de la gestion de fichiers et BDD

- Juridique

- Bibliographie

Jean-Michel Jurbert (Business Objects):

«Les entreprises se sont rendu compte que leur compétitivité ne dépendait plus seulement des solutions.»

A l'origine, la gestion de la qualité des données (ou Data Quality Management, DQM) est née d'un besoin de mise en conformité des résultats des banques et organismes financiers. Puis, elle a été adoptée par diverses directions opérationnelles, marketing notamment, afin d'améliorer la rentabilité de leurs campagnes. Segment des progiciels en très forte progression, notamment dans les pays anglosaxons, elle prend une importance croissante à mesure que le volume des bases de données augmente. «D'abord, les entreprises se sont équipées d'outils pour gérer et accumuler leurs données, comme un CRM. Puis, elles se sont rendu compte que leur compétitivité ne dépendait plus seulement des solutions adoptées mais aussi de la valeur des informations sur lesquelles elles fondaient leur stratégie», commente Jean-Michel Jurbert, responsable marketing produit chez Business Objects. Puisque la qualité de leur décision et le rendement de leurs actions découlent de leur base, la DQM est vite devenue une problématique financière. Selon l'organisme de formation et de recherche spécialisé The Data Warehousing Institute, le manque de qualité des données coûterait aux entreprises américaines plus de 600 milliards de dollars chaque année. «D'où une prise de conscience sur l'enjeu de la qualité des informations» , observe Laurence Chami, directrice commerciale chez Acxiom.

Avis d'expert

«Des outils pour assister la saisie en interactif»

Par Valéry Frontère, vice-président commission Etudes et Technologie du SNCD et directeur-fondateur de la société Amabis.

Plus personne ne songe aujourd'hui à contester l'utilité d'une base de données clients/prospects. Il s'agit même d'un enjeu capital pour nombre d'entreprises, pour qui la qualité des données est au coeur des préoccupations. Car si le formatage des données portées par des aspects réglementaires ou de gestion -comptabilité, commandes, stock est globalement satisfaisant, la nature même de l'information client -adresse, téléphone, e-mail peut la rendre rapidement obsolète.

Par ailleurs, la culture et le mode de vie des commerciaux et des marketeurs ne peuvent garantir une nécessaire homogénéité et pertinence. Pourtant, l'objectif est clairement défini: il faut vendre plus efficacement, donc mieux cibler et utiliser à bon escient le multicanal. Constituée de plusieurs types d'information - signalétique, comportementale ou production -, une base de données clients doit être orientée «utilisateurs finaux». Ce sont eux qui, au quotidien, sont en effet les premiers garants de la qualité et de la mise à jour de l'information. S'assurer de leur concours par un bénéfice utilisateur fort est une des premières règles du succès. De plus, les logiciels doivent présenter des accès simples, permanents et universels aux données.

Des outils ou prestations complémentaires permettent d'assister la saisie en interactif ou de la contrôler a posteriori, ce pour assurer la validité et la «fraîcheur». L'adresse géographique et postale revêt d'ailleurs un caractère majeur, car elle est plus descriptive du consommateur qu'un e-mail, volatile et parfois totalement anonyme.

C'est notamment via l'adresse qu'il est possible, par déduplication avec des référentiels externes, d'enrichir sa base avec des informations complémentaires: NAF, Siret, CA, interlocuteurs pour le B to B, IRIS 2000 et profil socio-démographique, et consommation pour le B to C. Ainsi constituée, utilisée, validée et mise à jour, la base de données peut fournir les éléments statistiques clés d'un ciblage chirurgical - avec des techniques de scoring- et devenir la plateforme opérationnelle d'actions multicanal, qui, par leurs retours, enrichiront à nouveau la base de données, alors plus précise pour effectuer les analyses décisionnelles...

Objectif rentabilité

Si le concept de la «DQM» peut paraître «obscur», ses objectifs ne peuvent être plus concrets. La DQM améliore la qualité de la base de données aussi bien sur le fond que sur la forme. Elle apporte les moyens de lutter contre l'obsolescence des informations grâce à des processus de mise à jour. Elle permet d'enrichir la connaissance client en augmentant la pertinence d'un scoring ou d'un profil comportemental. Elle réduit le taux de NPAI et améliore le rendement des campagnes marketing. Elle prémunit l'entreprise contre l'introduction de données erronées en vérifiant les informations en temps réel. Les segmentations deviennent plus pertinentes, les tableaux de bord plus fiables, les outils informatiques plus efficaces. En clair, la DQM a pour but d'optimiser l'apport des outils qui utilisent ces informations. Pour cela, elle s'attache à garantir la véracité de celles-ci à partir du moment où elles sont collectées et intégrées à une base de données.

Cela se traduit par trois objectifs distincts. D'abord, analyser les données et détecter les erreurs. Ensuite, corriger l'information en cas de besoin, grâce à la comparaison avec des référentiels, et éliminer les doublons. Enfin, administrer les données pour en assurer durablement la qualité.

Olivier Mansard (QAS):

«L'adresse est la donnée la plus utilisée en CRM ou en business intelligence.»

TIA: aux prémices de la DQM

L'application la plus courante de la gestion de la qualité des données est bien évidemment le Traitement informatique de l'adresse (TIA). Celui-ci se décompose en trois parties: la correction de l'adresse, dite «RNVP», l'enrichissement de l'adresse (numéro Siret, numéro de téléphone, coordonnées géographiques, etc.) et l'élimination ou le remplacement des données inutiles (doublons) ou périmées (traitement des déménagés). «L'adresse est la donnée la plus utilisée en CRM ou en business intelligence», rappelle Olivier Mansard, directeur général de QAS. Elle permet de cibler une campagne, d'enrichir les profils de données comportementales de l'Insee ou un numéro Siret, de calculer un potentiel de croissance ou de valider la création d'un nouveau magasin grâce au géomarketing. D'où une offre large et variée d'outils dédiés à cette information complexe.

@ Source: The Data Warehouse Institute, mars 2006.

Des traitements curatifs ou préventifs

Parmi les éditeurs d'outils, certains sont spécialisés par pays (comme Uniserv en Allemagne, QAS au Royaume-Uni, Normadl en France, Datatics en Irlande), tandis que d'autres traitent les adresses uniformément, quel que soit le pays d'origine (Group One Software avec Code One, AddressDoctor, Fuzzy Informatik avec Fuzzy Post, Human Inference avec Hlquality Address, etc.). La majorité de ces outils traitent les adresses de façon curative (ou «batch»), après l'intégration de l'information erronée dans la base. Une liste de ces solutions curatives, certifiées pour le marché français, est diffusée par le Service national de l'adresse (SNA). Celle-ci recense une quinzaine d'éditeurs. Mais elle n'est pas exhaustive car elle ne comporte aucun outil international. Une minorité de ces solutions fonctionnent de façon préventive (ou en «temps réel»), afin d'éviter qu'une adresse mal saisie n'entre dans la base. Il s'agit généralement de déclinaisons de produits «batch». La vocation de ces derniers: apporter une réponse à l'adage «Garbage in, garbage out» qui peut se traduire par «une donnée mauvaise donnera de mauvais résultats». Ces outils sont encore assez peu répandus, même si le marché tend vers une correction en temps réel de l'adresse. Apparues il y a 15 ans, les solutions de traitement RNVP ne répondent aujourd'hui qu'à une petite partie des besoins des entreprises. «Ce sont des outils de niche dont le spectre d'application est devenu trop étroit», reconnaît Bruno Labidoire, directeur technique d'Informatica. «Ils deviennent pour certains des briques technologiques d'acteurs plus complets», confirme Patrick Floch, directeur des ventes Europe du Sud de Business Objects. Celui-ci est bien placé pour le savoir: le spécialiste de l'informatique décisionnelle a acquis en septembre dernier l'Allemand Fuzzy Informatik.

Bruno Labidoire (Informatica):

«Un ETL doit assurer à l'utilisateur que ses données sont toujours justes.»

Avoir confiance en sa base

Ce rachat illustre parfaitement le cheminement des éditeurs de solutions plus globales: l'adresse n'est qu'une donnée, au même titre qu'une date, un nom ou un montant de facture. «La gestion de la qualité doit apporter aux entreprises une confiance en leurs données grâce à des outils qui les aident à connaître le niveau qualitatif de l'ensemble de leur base», définit Brigitte Laboisse, directrice technique d'AID. La DQM repose sur sept critères: complétude, intelligibilité, conformité, homogénéité, exactitude, disponibilité et unicité. La méthodologie classique, qui se compose de trois étapes, démarre par un audit qualitatif des données et de leur structure. «Celui-ci permet d'identifier où sont les erreurs et de créer les règles qui serviront, dans une seconde phase, à corriger et structurer les données», explique Christophe Chalopin, responsable Solution Data Intégration chez SAS. Jusqu'ici, ce processus s'avère assez proche de la correction d'adresses postales «batch», mais s'adapte à tout type d'information. Enfin, à l'instar de nombreux projets liés aux outils métier (CRM et décisionnel, par exemple), la gestion de la qualité comprend une phase itérative, permet- tant d'affiner en continu les méthodes de prévention contre le risque d'importer une information erronée.

Encore en structuration, le marché des outils de gestion de la qualité se développe parallèlement au volume croissant de données dans les bases opérationnelles et au besoin de les administrer. Les acteurs de la business intelligence l'ont parfaitement compris, car la satisfaction de leurs propres clients passe par l'obtention de meilleurs résultats. Parmi eux, les éditeurs d'«ETL» (acronyme d'Extract Tranform and Load), ces plateformes qui trouvent les informations, les manipulent et les réinjectent dans des systèmes décisionnels. Informatica, l'un des leaders de ce segment, a racheté Similarity pour ajouter à son produit des outils de DQM. «Manipulant les informations, notre plateforme doit assurer à l'utilisateur que ses données sont toujours justes», estime Bruno Labidoire. Une implication aussi forte que celle des spécialistes du data mining, comme SAS ou Business Objects. Tous proposent des outils dédiés, intégrés ou non à leurs solutions historiques. Le but: contenter le client et le fidéliser. Les outils de gestion globale de la qualité sont encore peu nombreux et assez méconnus en France. Parmi eux, on peut distinguer les outils d'audit des bases, les outils de correction et les solutions globales. Dans la première catégorie, se trouvent Data Insight XI de Business Objects, IBM Analyser d'IBM, BDQS d'AID, Fuzzy Dime de Fuzzy Informatik, ou encore Similarity Data Explorer d'Informatica. Dans la deuxième, dfPower Studio de Dataflux, Similarity Data Quality d'Informatica, Data Quality XI de Business Objects, DataStage d'IBM. Dans la dernière, Hlquality Suite d'Human Inference, Customer Data Quality Suite de Group One Software, Quality Suite de Trillium Software ainsi que les suites éponymes de

Dataflux, ou de Datalever. Mais pouvoir se reposer sur sa base de donnée a inévitablement un coût. Et ce dernier peut s'avérer vertigineux: à partir de 50 000 euros pour la suite de Dataflux; à partir de 30 000 euros pour IBM Quality Stage. Ces produits sont onéreux, même si certains exemples tendent à prouver que le retour sur investissement est assez rapide. Voici pourquoi le traitement classique des adresses, sujet à une forte concurrence et à des tarifs tirés vers le bas, a encore un bel avenir.

Brigitte Laboisse (AID):

«La gestion de la qualité doit apporter aux entreprises une confiance en leurs données.»

Médiacible multiplie les contrôles

Le département marketing de La Redoute emploie un panel d'outils pour vérifier la cohérence de ses informations. Un travail nécessaire compte de tenu de l'usage intensif que le VADiste fait de sa base de données.

Les vépécistes traditionnels n'ont pas attendu la montée en puissance de la DQM pour développer des processus visant à assurer la qualité de leurs données. Chez Médiacible, département marketing de La Redoute chargé de la gestion et de la préparation des données pour les campagnes, cette problématique est vitale pour le groupe. «L'enjeu est de satisfaire un client de plus en plus exigeant», confie Lionel Obin, directeur de Médiacible. Une satisfaction qui dépend de la bonne réception des colis mais aussi de la pertinence du ciblage des campagnes courrier. Il s'agit également de ne pas importuner ce consommateur exigeant avec une multiplication des messages sans intérêt et des sollicitations sur des canaux inappropriés.

8 millions d'acheteurs

Le contrôle de la qualité des données est fondamental chez Médiacible, car le volume des données est considérable: la taille de la base se calcule en teraoctets; plus de 8 millions de profils composent le fichier de La Redoute et 16 millions celle des 15 enseignes gérées par Redcats (La Redoute, Cyrillus, La Maison de Valérie, Vertbaudet, Fnac Eveil & Jeux, Fnac.com, etc.); au moins 700 variables comportementales qualifient chaque profil. En outre, plus de 32 millions de colis sont envoyés chaque année et plusieurs centaines de campagnes par an sont réalisées à partir de ces données. «La vérification des informations représente entre 50% et 80% du temps passé à obtenir la cible d'une seule campagne», constate Lionel Obin. Le risque d'erreur augmente donc chez Médiacible parallèlement au volume de données contenues dans les bases mais également au nombre de sources d'informations et d'outils qui les manipulent. Selon le directeur du département marketing, le manque de qualité peut provenir aussi des employés, des points de contact avec le client (centre d'appels, points de vente, plateforme de gestion des courriers entrants), des fichiers externes mal renseignés, des outils du système d'information ou des consommateurs eux-mêmes. «Le risque majeur n'est pas pourtant une donnée fausse mais manquante car une erreur peut toujours être corrigée», souligne Lionel Obin.

Un outil pour chaque fonction

Pour obtenir un résultat cohérent, Médiacible a choisi de s'appuyer sur des logiciels aux fonctions spécifiques. D'où une combinaison assez complexe de solutions qui interviennent à deux niveaux. D'une part sur la donnée ellemême grâce au traitement des adresses postales, le contrôle de composition des e-mails et la validation des données déclaratives au moyen de méthodes empiriques. Et, d'autre part, au sein des solutions qui alimentent les bases (ETL) et exploitent les informations (reporting et data mining), en consolidant les informations pour en vérifier la cohérence et l'existence, évitant ainsi les problèmes liés aux champs vides. Un choix en adéquation avec le marché des outils de DQM: les solutions agissant sur les données (Hlquality Address, Fuzzy Post, Code One) mais aussi les outils intégrés à des plateformes plus complexes (comme Business Objects ou Informatica).

Cet ensemble rigoureux prendra très prochainement toute son importance car Médiacible est chargé de mettre en place l'intégration de deux nouvelles sources d'informations: celles liées au comportement multicanal des clients (courrier, catalogue, asile colis, e-mail) et celles, innombrables, issues des visites réalisées par les internautes sur les sites du vépéciste. «Ce sera un véritable «tsunami» quand nous intégrerons les données en provenance d'Internet car leur nombre est considérable», prévoit Lionel Obin. Sans oublier les outils associés.

Lionel Obin (Médiacible):

«L'enjeu est de satisfaire un client de plus en plus exigeant.»

HD Assurances: - 90% de NPAI

Grâce à une meilleure gestion de la qualité de ses données, l'assureur à distance optimise le nombre de plis distribués et renforce sa rentabilité et son image.

Depuis 30 ans, HD Assurances gère par correspondance des complémentaires santé et commercialise des contrats spécifiques pour chiens et chats. L'exemple est éloquent: l'assureur compte 80 000 clients, 150 000 bénéficiaires et s'adresse surtout à eux via des campagnes de mailings et un site web. Il envoie 30 000 avis de remboursement par mois et 120 000 courriers commerciaux par an. Or, jusqu'en 2005, le groupe enregistrait un taux de NPAI de 20%. Un exemplaire de courrier marketing coûtant entre 7 et 8 euros, les pertes dues au manque de qualité de ses adresses atteignaient environ 180 000 euros par an. C'est pourquoi l'assureur a fait appel à Acxiom qui a pris en charge le nettoyage semestriel complet des données existantes, traite et intègre les adresses des contacts entrants (appels et coupons-réponse) et a déployé un outil de correction en temps réel des coordonnées postales saisies par la trentaine de téléconseillers de l'assureur. «Le nombre de NPAI a été réduit de près de 90%», résume Hubert Derai, président de HD Assurances. L'amélioration qualitative des adresses a aussi permis d'engendrer trois résultats. D'abord, l'entreprise réalise des économies sur ses campagnes marketing et sur ses actions de recouvrement. Ensuite, ces campagnes sont plus efficaces, la vision de sa clientèle est plus fiable et le temps de préparation des données moindre. Enfin, l'entreprise bénéficie d'une meilleure image auprès de ses clients et de ses prospects. «L'engagement financier pour maintenir notre base est important mais le retour sur investissement est très intéressant», commente Hubert Derai. L'assureur compte mettre en place des processus qualité similaires pour le canal web et réaliser bientôt des campagnes en ligne.

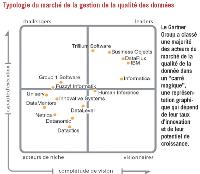

Un marché en déséquilibre

Selon le Gartner Group, le marché mondial de la qualité des données atteint déjà 300 millions de dollars. Un segment tiré par les pays anglo-saxons et qui touche seulement maintenant la France.

Le marché de la gestion de la qualité des données est en pleine effervescence. Les différents analystes spécialisés attendent une croissance à deux chiffres sur les cinq prochaines années à l'échelle mondiale, notamment grâce à la progression continue de l'adoption par les entreprises de progiciels métier. La DQM devrait croître parallèlement au CRM et à l'informatique décisionnelle, deux segments où les données sont très sollicitées. Le Gartner Group, un réfèrent en matière d'économie des technologies de l'information, a publié plusieurs études. Selon l'institut américain, la DQM représente aujourd'hui dans le monde 300 millions de dollars et devrait croître de 17,6% chaque année pour atteindre 677 millions de dollars en 2011. Une progression supérieure à celle du CRM (14%), ce qui peut sembler logique: le CRM est un marché de renouvellement tandis que la gestion de la qualité des données est en phase d'adoption. De plus, la DQM ne bénéficiera pas uniquement de la croissance du CRM, mais également de celle de l'informatique décisionnelle et de la gouvernance d'entreprise. L'évolution du chiffre d'affaires de Dataflux, l'un des leaders mondiaux de cette discipline, est un bon indicateur. La filiale de SAS connaît depuis 2000 une croissance à deux chiffres de son activité. «En 2007, nous devrions observer une augmentation de 20% de notre chiffre d'affaires», confie Colin Rickard, directeur général Europe de Dataflux. Dernier indicateur qui atteste de la très probable croissance du marché de la DQM, l'évolution du nombre des données stockées par les entreprises dans le monde. Le cabinet d'études IDC estime que 161 exaoctets (ou milliards de gigaoctets) de données ont été créés ou copiés en 2006, un chiffre qui devrait atteindre 988 exaoctets en 2010.

Le marché français en retard

La France, plus particulièrement, est loin d'avoir fini sa phase de popularisation de la DQM. D'abord parce que la croissance du CRM et du décisionnel y est moins marquée. Selon IDC, le marché français du CRM devrait croître en 2007 de 6,4% (en léger ralentissement par rapport à 2006), le marché du décisionnel de 9,5% et celui des ERP, beaucoup plus mature, de 9,4%. Ensuite parce qu'aucun des leaders de ce segment n'est français. Trillium Software, Dataflux, IBM, Group One Software et Informatica sont américains. Business Objects, le leader du reporting, est français mais ses deux filiales dédiées, FirstLogic et Fuzzy Informatik, sont américaine et allemande. Parmi les acteurs identifiés comme les spécialistes de la DQM par le Gartner Group dans l'édition 2007 de son «carré magique», seule Business Objects est à l'origine une entreprise française. En outre, une poignée d'entre eux sont présents en France, soit en propre via des filiales, soit via des partenariats commerciaux.