Les études quanti enrichissent leur territoire

Pilier du marché des études marketing, les études quantitatives ad hoc s'adaptent aux attentes des entreprises en recherchant plus de simplicité, d'opérationnalité et de valeur ajoutée. Et se tournent vers la prédiction, l'émotion... Tour d'horizon des grandes évolutions en cours.

Je m'abonne

Difficile de parler études quantitatives sans évoquer l'enjeu de l'innovation, tant le quanti ad hoc se place au coeur de toutes les logiques de lancement de nouveaux produits avec son cortège d'enquêtes sur les variables du mix. Selon le cabinet de veille marketing XTC, plus de 20000 concepts sortent, chaque année, dans le monde sur le seul marché de l'alimentaire. Et selon une enquête de TNS Worldpanel, un tiers des ventes se réalisent sur des produits qui n'existaient pas trois ans plus tôt. Pourtant, près du tiers des innovations (29%) disparaissent avant un an, la moitié avant deux ans et pratiquement les deux tiers à l'issue de la troisième année. Devant un taux de survie aussi faible, les études cherchent à affiner leurs méthodes pour apporter des solutions encore plus pertinentes aux problématiques de l'entreprise.

Du constat à la prévision

«Nous constatons une attente déplus en plus forte des clients pour que l'ensemble des études réalisées pour eux annoncent ce qui va se passer dans les deux ou trois prochaines années, constate Raphaël Ventura, directeur associé au sein de l'Unité Consumer de TNS Sofres. On est désormais moins dans le constat que dans la prévision.» D'où la création par TNS Sofres d'un indicateur, le CSI (Concept Screener Index) , obtenu après confrontation des performances des concepts en phase de test «Concept Screener» avec les performances marché, une fois ces concepts lancés (via les données panels issus de TNS Worldpanel) . Le CSI est prédictif du taux d'essai et a été validé début 2006. C'est également l'an dernier que TNS Sofres a lancé Launch Maximiser, son marché test, simulé on Une. Cette année, avec la méthodologie FutureView, l'institut essaye d'identifier les individus déterminants dans l'évolution de tel ou tel marché.

De nombreux outils ont été développés pour répondre à cette attente de prédictivité. Depuis les tests de communication jusqu'aux prévisions des volumes achetés. OTO Research, filiale de FullSIX, met actuellement en oeuvre une méthode, inventée par la société italienne, pour construire un modèle permettant d'anticiper le nombre de personnes converties par un mailing. «C'est un modèle qui s 'appuie sur des données historiques tous médias on et off Une, que nous avons développé en partenariat avec un grand institut de statistiques et qui crée une relation mathématique entre l'exposition et la conversion», précise Pierre Santamaria, tout nouveau directeur général d'OTO Research. La prise en compte de l'efficacité des actions marketing (above and below the Une) devient décisive dans la prédiction des ventes, c'est pourquoi les outils quanti s'appliquent à tous les médias. Les chaînes W9 et TMC ont ainsi rejoint le dispositif de tests publicitaires, BehaviorScan, qui intègre déjà Internet dans ses décrochages régionaux. Autre sujet d'intérêt de la part des clients et instituts: le buzz. Bases, par exemple, est en train de réfléchir à la façon d'intégrer de manière quantitative l'effet du buzz dans la création de notoriété et de contenu.

«Le besoin de prédictivité est très fort en publicité, car les entreprises ont besoin de garantir leur retour sur investissement, remarque Thomas Tougard, directeur général d'Ipsos Marketing. C'est pourquoi nous avons développé des tests de publicité, prédictifs de l'efficacité sur les ventes.» Impact Mémoire (IM!), qui fait appel aux sciences cognitives pour construire ses prétests quantitatifs de campagne, a enrichi cette année sa gamme avec Pack Expert, réalisé en partenariat avec Repères, pour tester rapidement les projets de packaging. Le produit mixe l'expertise mémorielle d'IM! et le diagnostic quantitatif de Repères. L'institut a également lancé, en 2007, Be-Op. Ce dispositif combine l'analyse mémorielle d'une campagne diffusée en réel sur une zone test avec un post-test quantitatif, afin de voir les résultats de cette campagne avant sa diffusion nationale.

Chez BVA, sont développées des solutions d'aide à la décision fondées sur de la modélisation, elle-même basée sur de l'enquête et de l'observation du comportement. Ces études sont souvent utilisées en optimisation de réseaux de points de vente. «Cela nécessite une triple expertise: en enquêtes, en études marketing et statistiques ainsi qu'en géomarketing, reconnaît Xavier Pacilly, directeur d'activité Marketing de Services chez BVA. C'est un positionnement que notre institut veut renforcer.» Exemple récent: l'enquête ADCI qui identifie et permet de prévoir des comportements d'achat sur le territoire français (10000 ménages Insee).

Depuis peu, Adwise Research propose Brand Rating, un nouvel outil d'études on line norme, appartenant à la famille de la Brand Equity et qui évalue une marque sur trois niveaux: sa force actuelle, sa force prospective/potentielle et sa force globale. «Travailler sur la force potentielle permet de voir combien de temps un concept peut durer», explique Florence Hussenot, dg d'Adwise Research. Le modèle donne la possibilité de mesurer si le potentiel d'une marque est positif ou négatif. On parle de «potentiel négatif lorsqu'il y a moins de gens ne connaissant pas la marque et qui ne veulent pas l'essayer que de gens la connaissant et voulant l'essayer.

Avec sa méthode GfKInnovalue, GfK a voulu répondre à trois questions stratégiques que se posent les annonceurs: Quelle est la valeur de mon innovation? Quels sont ses volumes prévisionnels? Comment optimiser la valeur de mon innovation, et, au final, sa rentabilité? «Cet outil identifie la valeur de l'innovation, c'est-à-dire le rapport innovation/prix, et intègre la notion de réachat», souligne Sébastien Spangenberger, directeur associé de GfK Custom Research. De son côté, avec PriceSolve, Research International tient compte du fait que les consommateurs ont des attentes tant vis-à-vis des prix que de la valeur des nouveaux produits ou services. Avant de simuler leur choix, il convient donc de comprendre comment les prix envisagés peuvent correspondre à leurs attentes.

Quoi de neuf dans les marchés tests simulés?

Avis d'expert Michel Bendavid, dg de Stratégie Research, détaille les axes à suivre pour mieux estimer la visibilité.

L'innovation dans le domaine des marchés tests simulés est difficile. On sait que la qualité d'un marché test réside dans deux aspects: la qualité du modèle lui-même (pas de bonne prédiction sans bon modèle) et d'autre part, la profondeur de la base de données, parce que c'est la base d'expérience, c'est-à-dire la confrontation du modèle à la réalité, qui ajuste au cours du temps les paramètres et affine les prévisions. Ces deux conditions sont d'égale importance dans la qualité de la prévision.

Plusieurs instituts ont essayé, sans grand succès, de développer de nouveaux modèles pour concurrencer notamment Bases qui s'est imposé comme le modèle de référence en matière d'estimation de potentiel de ventes. Ces approches, parfois intéressantes, n'ont pas réussi à s'imposer faute d'un track record suffisant. Sans doute, les évolutions récentes les plus significatives concernent l'amélioration des modèles visant à intégrer les données du plan marketing dans la prévision.

Pour rappel, les estimations de vente croisent les données issues de l'étude (qui partent sur l'hypothèse d'une notoriété et d'une distribution de 100% pour le nouveau produit) et la réalité des moyens marketing qui seront engagés lors du lancement (investissements publipromotionnels, construction de la DV, etc.). Les moyens marketing jouent évidemment un rôle déterminant dans le succès ou l'échec d'un lancement. Des efforts significatifs ont été engagés pour mieux estimer la visibilité. Cela passe par plusieurs axes:

- Forcer les équipes marketing à ne pas surestimer les investissements qui seront effectivement engagés (pour tirer l'estimation du modèle à la hausse et forcer la décision du lancement). Cela demande une validation par le management des hypothèses d'investissements incluses dans la modélisation. Une mesure impopulaire parmi les équipes marketing mais qui va dans le sens d'une plus grande responsabilisation.

- Améliorer l'estimation de la notoriété future du nouveau produit en injectant des données historiques de construction de la notoriété dans la catégorie concernée.

- Mieux prendre en compte la plus grande variété des médias utilisés: sur beaucoup de marchés, on enregistre un transfert des investissements de la marque au point de vente, une bascule des dépenses «above the line» vers le «below the line». La prise en compte de l'efficacité des actions marketing, selon leur nature, devient décisive dans la prédiction des ventes. Ces initiatives vont, sans aucun doute, dans le sens d'une amélioration de l'efficacité des modèles.

Jérôme Simulin (Bases):

«Les annonceurs ont besoin d'efficacité. A nous de leur apporter des solutions qui les aident et fournissent des résultats faciles à comprendre, à mettre en place et à communiquer.»

Thierry Pailleux (Synovate France):

«Les clients n'ont plus besoin d'études qui refont le monde, mais d'études plus pointues, répondant vite à quelques questions légères.»

Prise en compte du linéaire

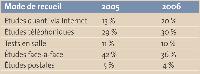

@ Source: Syntec Etudes Marketing & Opinion

Evolution des modes de recueil des études quantitatives en France

Autre attente: aider à modéliser les performances globales d'un ou de plusieurs scénarios d'assortiment. C'est la raison du lancement par l'institut Stratégir du produit Assorteam, qui vient compléter la gamme de tests de potentiel Bridge. «Ce type d'études aide à optimiser la négociation des référencements avec la distribution sur des bases solides et quantifiées», estime Luc Milbergue, dg de Stratégir. La prise en compte du linéaire est également à l'origine de nouveaux outils chez Bases. «Bases a créé le marché des MTS (marchés tests simulés, NDLR) il y a trente ans. Nous voulons contribuer à faire évoluer ce marché», souligne Jérôme Simulin, vice-président Client Consulting Europe Middle East 8c Africa chez Bases, qui rappelle que la société consacre 5 à 10% de son chiffre d'affaires à la R&D. L'an dernier, Bases a racheté à Procter & Gamble le produit Décision Point (devenu depuis Bases Décision Point), un outil qui améliore l'efficacité des stratégies aux points de vente. Autre nouvel instrument, le Bases Find Time qui permet de constater si un produit a suffisamment de visibilité en linéaire et d'éviter les problèmes de confusion du packaging. De son côté, Launch Maximizer de TNS Sofres intègre Visit qui prend en compte le linéaire.

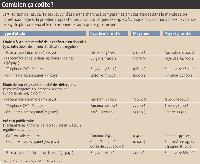

La domination des études quanti

- Dans le monde, les études quantitatives (y compris les études en continu, les études barométriques et les panels) représentent près de 83% du marché total des études. Lequel pesait 24,6 Md$ en 2006, selon l'enquête annuelle d'Esomar. En France, en 2006, selon Syntec Etudes Marketing & Opinion, les études quantitatives ad hoc constituaient 52% du marché total des études en France, qui a atteint 1,85 MdEuros cette année-là. Si l'on ajoute à ce chiffre, les panels et études en continu, barométriques et omnibus, les études quantitatives pesaient 85% du marché des études en France.

Des études plus simples et plus fines

«Nos clients n'ont plus besoin d'études qui refont le monde, mais d'études plus pointues, répondant vite à quelques questions légères, tout en restituant la même qualité d'information et avec des bases de données», constate Thierry Pailleux, directeur général de Synovate France. La société a ainsi lancé MarketQuest, un ensemble d'outils quanti permettant de gérer la chaîne de l'innovation, depuis le test de conceptjusqu'à la prévision des ventes. «C'est la même démarche qu'un MTS, mais sans la lourdeur de ce dernier», estime-t-il.

Du côté d'Ipsos, les prédictions de ventes sont intégrées dès le concept screening. «Nous sommes passés d'une notion de moyenne à une notion de norme, explique Thomas Tougard. Les MTS ont le vent en poupe car la décision d'investir dans un nouveau produit nécessite d'avoir, pour le directeur marketing, des informations sur le ROI. Mais, pas à n'importe quel prix. Le marché a besoin d'approches plus légères, notamment via Internet.» Toutefois, Marc Papanicola, dg de Research International France, met en garde: «Prédire reste un exercice particulièrement difficile sur les cycles d'innovation produit à trois ou quatre ans. Il faut demeurer réaliste. Si les conditions de l'environnement - concurrence, économie, attentes, etc. - changent entre l'étude préalable et le lancement du produit, l'exercice «prédictif» sera alors considérer avec précaution.» Parallèlement, le besoin de diagnostic devient de plus en plus présent. «Nous sommes déplus en plus challenges sur le fait de savoir comment optimiser des volumes lorsqu'ils ne sont pas suffisants au regard des objectifs, que ce soit en termes de positionnement prix ou en termes de stratégie de communication, constate Luc Milbergue. Nos clients demandent aux nouvelles générations de tests de potentiel d'aller beaucoup plus loin dans le diagnostic marketing et l'accompagnement des équipes pour retravailler leurs projets, si nécessaire.»

Bases a identifié une attente nouvelle de ses clients: hiérarchiser les positionnements sur lesquels ils vont pouvoir développer leurs innovations. L'approche Bases MBA (Market & Brand Advisor) aide ainsi à développer des concepts sur les drivers importants. «C'est une solution stratégique pour définir le squelette de la marque et la construire au travers de l'innovation», explique Jérôme Simulin. Pour être encore plus opérationnels et faciliter l'analyse par les équipes marketing du client, les résultats Bases se décomposent désormais de la même façon que les grands résultats Nielsen. «Nos tests de potentiels utilisent les mêmes indicateurs que les panels Nielsen, comme le taux d'essai, de ré-achat, la quantité achetée à l'essai, au ré-achat, la fréquence..., détaille Jérôme Simulin. Nos clients ont besoin d'efficacité. A nous de leur apporter des solutions qui les aident et fournissent des résultats faciles à comprendre, à mettre en place et à communiquer.»

Anne Lerner (GfK Custom Research):

«Nous menons un travail de R&Dpour valider quantitativement la signification d'une photo ou d'un contenu verbal.»

L'alliance avec le quali

Traditionnellement, le quali intervenait en amont pour explorer, le quanti venait ensuite pour confirmer ou infirmer hypothèses et pistes de travail. Depuis quelques années, un mouvement général se dessine et gomme la frontière entre les approches qualitatives et quantitatives. «Délimiter une frontière est plus que jamais un exercice purement technique, d'ailleurs vieillissant, à la fois pour des raisons technologiques liées au on line, mais aussi parce que les acheteurs d'études attendent «plus et plus vite»», constate Marc Papanicola. Les sociétés d'études sont donc amenées à travailler sur ces deux techniques en estompant leur frontière. Et même si celle-ci est maintenue pour des questions d'organisation interne ou de logistique de production, elle ne l'est pas pour des raisons de stratégie client. Pour Jean-Michel Soleau, dg de BVA'Reason Why, «les plus belles études et certainement les plus sécurisantes pour nos clients sont les études quali/ quanti». Travailler sur des sujets combinant les deux approches, à tout moment de l'étude, est de plus en plus pratiqué. Le on line ouvre d'ailleurs la voie à une approche qui gomme toute distinction, le qualiquanti. «Avec Internet, on peut facilement recueillir un grand nombre de retours qualitatifs et l'informatique permet d'analyser facilement beaucoup de données. Plus besoin de choisir entre la force du nombre et la profondeur de l'interrogation. Nos questionnaires sont conçus comme des entretiens semi-directifs structurés», explique Daniel Bo, président de QualiQuanti.

Mesurer l'émotion

L'émotion est aujourd'hui au coeur des réflexions marketing. Les besoins rationnels ayant été dans la grande majorité des cas comblés par les produits et services, les innovations cherchent à convaincre les consommateurs en essayant de se différencier sur le terrain de l'émotion. Les études qualitatives sont traditionnellement à même de saisir les aspects les plus tangibles des représentations ou des discours et de livrer des clés d'interprétation pertinentes. «Sur le marché, apparaissent des solutions qui touchent la dimension émotionnelle en quantitatif et qui corrigent l'inaptitude - intrinsèque au quanti - à mesurer des concepts échappant au territoire rassurant du cognitif», reconnaît Michael Bendavid, dg de Stratégie Research. Dans cet esprit, Ipsos a lancé un Perceptor Emotion qui mesure les drivers fonctionnels et émotionnels. Chez Synovate, l'approche Censydiam s'appuie sur un modèle de compréhension du consommateur à partir de théories psychologiques et comportementales. «Le modèle Censydiam est basé sur une structuration de la psychologie de l'individu dans sa quête de régulation rationnelle et émotionnelle des tensions», explique Thierry Pailleux. Dans ses trackings, et notamment Link, Millward Brown prend également en compte l'émotion par le biais de la trace et de l'engagement.

Les principaux outils existants qui cherchent à mesurer l'émotion (marque, campagne de publicité, etc.) utilisent l'approche par visuels. Il en est ainsi de Needscope de TNS Sofres, Emotiscape d'Ipsos Marketing, de l'outil de Research International, etc. Le débat aujourd'hui est de savoir lequel du verbal ou de l'image cerne le mieux l'émotionnel. GfK mène une étude sur cinq pays européens qui vise à tester une approche en images et une approche verbale. «Nous voulions voir si l'on parle des mêmes choses, note Anne Lerner, directrice associée de GfK Custom Research. Nous allons tester ces approches en Europe et voir si nous pouvons les extrapoler à d'autres zones géographiques. Le travail de R&D que nous menons consiste à valider quantitativement la signification d'une photo ou d'un contenu verbal.» Développer des visuels qui puissent fonctionner dans des pays où la culture est différente représente un travail lourd. «Pour mesurer l'émotion, il faut sortir des bornes et travailler avec une sémantique différente ou développer des échelles infinies. De toute façon, il faut trouver des approches et des outils différents», insiste Florence Paulin, directrice du département Grande Consommation de BVA.

Parallèlement, les neurosciences viennent s'inviter au débat sur la mesure de l'émotion en quanti. Lors du dernier Congrès Esomar qui s'est tenu à Berlin, une matinée a été consacrée à ce sujet. Emotion Technology y a notamment présenté, pour son client Bang & Olufsen, une nouvelle façon de mesurer les réactions émotionnelles à une campagne de publicité par la dilatation de la pupille. Et déjà, de nouvelles pistes sont en préparation. Les prochains axes de développement de Research International porteront sur la sensorialité comme troisième prisme d'appréhension du produit ou même du service. «Nous entrons dans une ère où le consommateur demande une «expérience intégrale». Et c'est ce que nous allons mesurer avec un module sensoriel transposable à un maximum d'univers», annonce Marc Papanicola.

Sur ce sujet lisez aussi

Le quanti, entre simplification et sophistication (MM 91, décembre 2004)

e-marketing.fr

LE SITE DES PROFESSIONNELS MARKETING